在深度学习的神奇世界里,激活函数扮演着至关重要的角色。它们就像是神经网络中的「开关」,决定着信息如何在网络中流动。今天,我们要探索一种名为SILU(Sigmoid Linear Unit)的激活函数,它因其独特的特性和潜在的优势而受到关注。

什么是SILU激活函数?

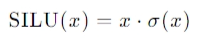

SILU是一种新型的激活函数,它的数学表达式简单而优雅:

[ \text{SILU}(x) = x \cdot \sigma(x) ]

这里的 ( x ) 是输入信号,而 ( \sigma(x) ) 是sigmoid函数,它将输入压缩到0和1之间。SILU函数的输出范围是从0到 ( x ) 的值。

SILU的魔力在哪里?

- 自归一化特性:SILU的输出自动适应输入的大小,这有助于防止梯度消失或爆炸,从而提高网络的训练效率。

- 非单调性:与ReLU等单调激活函数不同,SILU可以在正负值之间转换,提供更丰富的信息处理能力。

- 参数效率:在一些情况下,SILU能够减少模型所需的参数数量,使模型更加轻量化。

SILU在实际中的应用

虽然SILU是一个相对较新的激活函数,但它已经在多个领域展现出潜力。研究人员发现,SILU可以提高某些深度学习模型的性能,尤其是在图像分类和自然语言处理任务中。

如何使用SILU?

在实际应用中,使用SILU就像使用其他激活函数一样简单。在构建神经网络时,你只需在适当的位置插入SILU函数,然后让数据流经它。例如,在Python的深度学习库中,你可以这样使用SILU:

import torch

import torch.nn.functional as F

x = torch.randn(1, requires_grad=True)

output = F.silu(x)结语

SILU激活函数代表了深度学习领域的持续创新和发展。随着研究的深入,我们期待SILU能够在更多场景下发挥其优势,帮助我们构建更加智能和高效的模型。

想要了解更多关于SILU的信息,或者在你的项目中尝试使用它,可以查阅相关的研究论文。让我们一起见证深度学习技术的进步,并探索SILU的无限可能!

希望这篇博客文章能够帮助你更好地了解SILU激活函数,并激发你探索和应用这项技术的兴趣。如果你有任何问题或需要更多信息,请随时与我联系。

发表回复

要发表评论,您必须先登录。